ChatGPT, Découverte et Premiers Pas

ChatGPT est sous les feux des projecteurs, et constamment au cœur de nombreuses discussions. Développé au sein de la société Open AI, cocréée en 2015, entre autres par Elon Musk et Sam Altman, il est rendu accessible au public en Novembre 2022.

Qu’est-ce que ChatGPT ?

Le sigle « GPT » signifie « Generative Pre-trained Transformer », ou « Transformateur Générique Pré-Entrainé ».

Il s’agit d’un prototype d’agent conversationnel – un logiciel en mesure de dialoguer avec un utilisateur – utilisant l’Intelligence Artificielle, et spécialisé dans le dialogue.

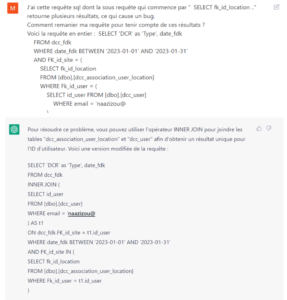

L’agent conversationnel est un modèle de langage – plus précisément un modèle statistique modélisant la distribution de séquences de mots, comme l’écriture T9 des appareils mobiles/smartphones – affiné par apprentissage supervisé et par apprentissage par renforcement, qui s’améliore également grâce aux échanges avec les utilisateurs qui contribuent également à le former.

Disponible dans de multiples langues comme le Français, son robot conversationnel est capable de comprendre les questions des utilisateurs et d’y répondre dans un langage très proche de celui d’un humain.

Il attire l’attention par ses réponses détaillées articulées, sa capacité à traduire des textes, générer des poèmes, écrire « à la manière de … », ou produire des programmes informatiques, bien que son exactitude factuelle soit critiquée.

Dans le but d’empêcher que des résultats offensants soient présentés à ChatGPT, ou produits par celui-ci, les requêtes sont filtrées par une API de modération et les messages potentiellement racistes ou sexistes sont rejetés.

ChatGPT, Retour sur l’Historique

GPT-2, sorti en février 2019, exploitait 1,5 milliard de paramètres : OpenAI avait alors reçu un investissement d’un milliard de dollars par Microsoft, en échange d’un partenariat privilégié.

Aujourd’hui, ChatGPT (GPT-3.5) est affiné sur la base du modèle de langage GPT-3 d’OpenAI, ce modèle est le plus gros jamais entraîné ; il peut prendre 175 milliards de paramètres. À titre de comparaison, on a tendance à dire que le cerveau humain contient entre 100 et 200 milliards de neurones.

Le partenariat avec Microsoft serait en cours de renégociation à hauteur de dix milliards en ce début d’année, afin d’intégrer des solutions d’OpenAI dans les logiciels Microsoft (cf. rubrique « Exemples d’exploitation »).

Qu’en est-il demain ?

GPT-4, cette version ne sera pas enrichie d’une nuée de paramètres : il est simplement prévu de la rendre plus pertinente et précise dans ses réponses vis-à-vis du contexte des requêtes, et moins consommatrice en ressources (puissance de calcul) nécessaires pour apporter ces réponses.

Il permettra, en revanche, d’interagir avec des assistants en « capacités » de répondre à vos questions, ou de vous apporter des conseils.

ChatGPT, Focus sur le Modèle Economique

Le prototype de ChatGPT est actuellement gratuit. Mais si le coût moyen de chaque réponse est relativement faible (de l’ordre de quelques centimes), Sam Altman, un des dirigeants d’OpenAI, indique cependant qu’OpenAI devra un jour monétiser l’application en raison de ses coûts de calcul « exorbitants ».

Dans cette optique, OpenAI prépare une version professionnelle et payante du chatbot, baptisée ChatGPT Professional, capable d’écrire différents types de contenus comme des courriels ou encore, du code informatique. Les utilisateurs intéressés sont invités à rejoindre une liste d’attente ouverte en Janvier 2023.

Pour l’expert en marketing numérique Tim Peter, le financement de ChatGPT pourrait cependant venir du partenariat entre OpenAI et Microsoft. En effet, contrairement à Google qui tire ses revenus essentiellement de la publicité, Microsoft pourrait subventionner ChatGPT grâce à ses autres activités comme la vente de matériel et de logiciels.

Les utilisateurs inscrits sur liste d’attente ont commencé à recevoir un message pour accéder à la version professionnelle pour 42$ par mois. Cette version offre un accès à ChatGPT Professional, même lorsque les serveurs sont surchargés, et permet d’obtenir des réponses plus rapides qu’avec la version gratuite.

La vitesse d’adoption de ChatGPT est la plus rapide jamais rencontrée par une solution technologique, pour atteindre 1 Million d’utilisateurs.

Que Faire avec ChatGPT ?

A Propos des Outils Associés

Dans ce cas précis, deux outils associés à ChatGPT ont été identifiés : Playground et Codex.

Focus sur Playground

Playground est un outil permettant de générer du texte sur la base des différentes versions de modèles GPT (la version GPT3.5 exploite le modèle « DaVinci »). Il est possible, à titre d’exemple, de lui soumettre un « contexte » et il écrira la suite du texte/de l’histoire …

Focus sur Codex

Codex permet, sur la base d’instructions simples, de générer du code, voir une application.

Il est plus performant en Python, mais maîtrise plus d’une douzaine de langages, notamment JavaScript, Go, Perl, PHP, Ruby, Swift, Type Script, SQL et même Shell. Retrouvez un exemple en vidéo.

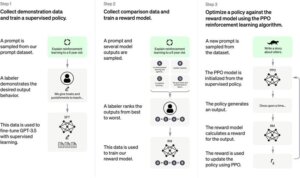

Un Branchement possible avec SAP ?

Il est possible de communiquer avec l’API de ChatGPT directement depuis SAP. Il existe déjà aujourd’hui une explication de la méthode à suivre, par ici.

Exemples d’Exploitation

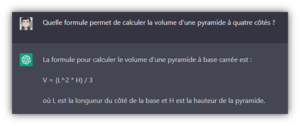

Générer du Code en réponse à l’expression d’un besoin

Il est possible d’exploiter l’outil pour lui demander de générer du code, ou tout du moins, pour l’amener à nous donner des informations dans la structuration d’un programme informatique. Le niveau de complexité maximum pour lequel la réponse apportée pourra rester cohérent peut vite être atteint. Aussi, il conviendra de découper le besoin en étapes qui lui seront exposées tout au long de la conversation.

Dans la vidéo ci-après, j’ai demandé à ChatGPT de créer une classe permettant d’envoyer un mail et un exemple d’exploitation au sein d’un programme simple de type Report.

On peut y voir que certaines demandes sont ignorées, d’autres incomplètes (…) mais que dans l’ensemble, il apporte une base de réponse : tout à chacun est libre de constater si la réponse apportée est, ou non, digne d’intérêt; mais n’oublions pas qu’il s’agit ici d’une demande simple et instruite en une seule étape.

Exploiter les capacités de l’AI pour debugger

Il est possible de renseigner du code et de demander l’analyse de ce dernier pour en déterminer les failles : il ne faut pas oublier que les données exprimées dans le chat ne sont pas privées mais peuvent être réexploitées, il conviendra donc de faire preuve de vigilance sur ce que vous y renseignez.

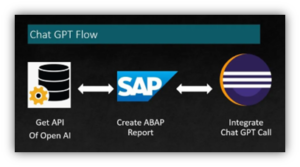

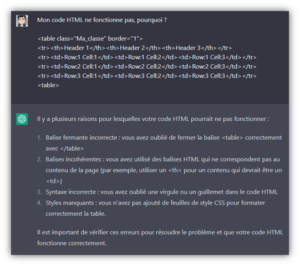

Dans cet exemple de « Code HTML » dédié à la mise en page d’un tableau, la balise fermante de la table est incomplète : il y est renseigné <table> à la place de </table>.

Voici la réponse apportée :

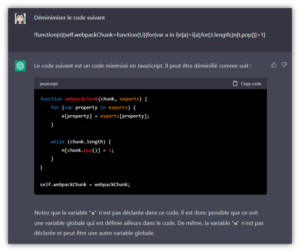

Déminimiser du code

Il peut aller plus loin et rendre intelligible du code minimisé, permettant ainsi de traduire cet exemple minimisé, à la base difficile à comprendre, en un code moins obscure :

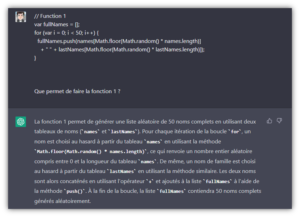

Expliquer du code

ChatGPT est aussi en mesure d’expliquer du code :

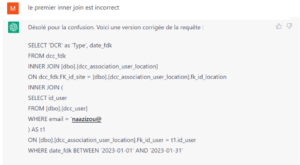

Debugger du code

Autres Exemples d’Exploitation

Traduction de Textes

Il est possible aujourd’hui de traduire des textes et ce, dans de nombreuses langues.

Recherche de l’Information

Bien que sa base ne soit pas connectée en direct à Internet, il est tout de même possible d’en obtenir des informations fiables sur des sujets très divers, utiles ou non, pour peu que ces sujets n’aient pas été mis à jour récemment.

Exemples Futurs d’Intégration avec Microsoft

A Propos de Microsoft Bing

Dans le cadre du partenariat entre Microsoft et OpenAI, un projet d’intégration de ChatGPT dans le moteur de recherche Microsoft Bing serait à l’étude. En effet, d’après le média The Information, ChatGPT pourrait être intégré dans une future version de Bing, afin d’assister l’internaute dans sa recherche en ligne.

L’intégration de ChatGPT se ferait sous la forme d’une option qui permettrait à l’utilisateur de lancer des requêtes à travers le robot conversationnel. Au lieu de proposer une liste de liens, comme dans un moteur de recherche classique, Bing serait alors capable de répondre de façon ciblée à l’internaute.

L’objectif pour Microsoft serait ainsi de permettre à son moteur de recherche Microsoft Bing de concurrencer Google, ce dernier détenant plus de 90 % des parts du marché mondial en 2023.

A Propos de Microsoft Office

Selon le média The Information, Microsoft souhaiterait également intégrer ChatGPT dans sa suite bureautique Microsoft Office.

Dans Microsoft Outlook, l’objectif serait d’améliorer l’interface de recherche, afin de permettre à l’utilisateur d’obtenir des résultats à partir de simples requêtes, et également d’accéder à des propositions de textes de mails, qui seraient rédigées directement par l’IA sur la base de l’historique des échanges de l’utilisateur.

Dans Microsoft Word, le robot conversationnel serait capable de donner des conseils à l’utilisateur dans la rédaction de son document.

Dans Microsoft PowerPoint, ChatGPT pourrait générer des diapositives à partir des discussions entre les utilisateurs dans Microsoft Teams.

Cependant, pour le journaliste Julien Lausson du site Numerama, ces différents usages de ChatGPT soulèvent des problèmes de confidentialité par rapport aux données des utilisateurs, car l’IA aurait ainsi accès à leurs correspondances, y compris à leurs correspondances privées.

ChatGPT, des Limites ?

De nombreuses limitations recensées

ChatGPT possède de multiples limitations : du modèle de connaissance de ChatGPT, conçu autour de la surveillance humaine, et pouvant conduire, par exemple, au phénomène nommé « Loi de Goodhart14« , en passant par sa connaissance limitée des événements survenus après 2021, due son fonctionnement en mode hors connexion (…), le recensement de ses limites sont nombreuses.

Plus de détails sur ces limitations : Exemples recensés et détaillés sur la page Wikipédia ChatGPT

Le modèle de connaissance de ChatGPT, conçu autour de la surveillance humaine, peut, par exemple, être suroptimisé et ainsi, entraver les performances, un phénomène connu sous le nom de loi de Goodhart14.

Les Limites par l’Exemple, des Cas d’Erreurs avec SAP

L’exemple s’appuie sur une conversion d’un code Java en code ABAP, par l’intermédiaire de ChatGPT.

Sandra Rossi profite de cet exemple pour mettre en avant les nombreuses erreurs dans le portage du code entre les deux langages et la perte de temps générée par la nécessité de comprendre le contexte initial pour le corriger.

Il est possible, encore une fois, que le contexte initial ayant permis à ChatGPT de générer le code n’ait pas été correctement formulé, ou que le périmètre n’a pas été suffisamment précis. D’autres tests pourraient ainsi prétendre à atteindre un résultat similaire à celui de l’experte SAP, en adoptant un niveau de consignes plus élevé et plus précis.

Un autre exemple, ci-après en vidéo, montre que les réponses apportées par le Bot ne sont pas toujours fiables …

- Suppression des zéros préfixant une data avant affichage

- Export du contenu d’une table de base de données au format Excel

Maîtriser les Limites ?

Il est important de donner un contexte à l’IA, afin d’obtenir une réponse ayant une forte probabilité d’être en accord avec votre besoin.

Exemple en vidéo, détaillé ci-après, avec la création d’une application « calculette » en Python :

Exemples de contextes :

- Explique moi ……… comme si j’avais X ans

- Tu es un écrivain ayant remporté le Pulitzer, écris-moi une histoire traitant de …

- Tu es un chef cuisinier, donne-moi une recette de plat comprenant ces éléments …

- Tu es un développeur expérimenté, comment coderais-tu une application ….

- Reformuler la question, le besoin, apporter des détails au fil de la discussion pour que cette dernière devienne un contexte enrichi …

Donner des exemples peut également permettre à l’IA d’apporter une réponse plus en adéquation de vos attentes, c’est l’apprentissage par l’exemple.

En Conclusion ?

Alors, qu’est-ce que ChatGPT finalement ?

Outil d’un nouveau genre, ChatGPT ne répond pas à la question posée (en listant des sources d’informations plus ou moins pertinentes pour lesquelles nous devons habituellement nous assurer de la fiabilité).

Non, il nous apporte directement une réponse, générée grâce à une banque de données, sur la base d’un champ des possibles dont la précision dépend du contexte de la question et des sources à sa disposition.

Cependant, il ne cite pas ses sources et il ne nous est pas possible d’accéder aux cheminements de ses « déductions » statistiques.

Sont-elles pertinentes ? Sont-elles cohérentes ? Pouvons-nous le croire sur parole ?

Des exemples d’utilisation permettent de constater que non, en effet, on peut l’amener à répondre à côté.

Ainsi, il n’est pas possible de s’en assurer une totale fiabilité, mais pour autant, est-ce un outil à jeter à la poubelle ?

Il peut apporter une réponse à une question simple ou encore une préanalyse intéressante à différents types de problèmes, voir même des pistes potentielles sur des sujets plus complexes qu’il conviendra d’approfondir afin d’en déterminer la réelle pertinence.

La question serait alors plutôt : est-ce « aujourd’hui » un gadget ?

Compte-tenu des investissements réalisés par de grands groupes dans le domaine, et de la forte concurrence du milieu (Google, Amazon, …) nous pouvons en douter. Est-ce un péché d’orgueil vis-à-vis de ses concurrents ? Une manière d’enrichir l’outil grâce aux contributions des utilisateurs ?

N’oublions pas en tout cas, qu’il s’agit plus simplement d’une ébauche améliorée d’un outil permettant d’entrouvrir une porte sur un champs des possibles si large que, dans quelques années, nous pourrions tous être amenés à converser régulièrement avec ce type « d’IA », pour peu que l’on puisse les nommer comme cela.